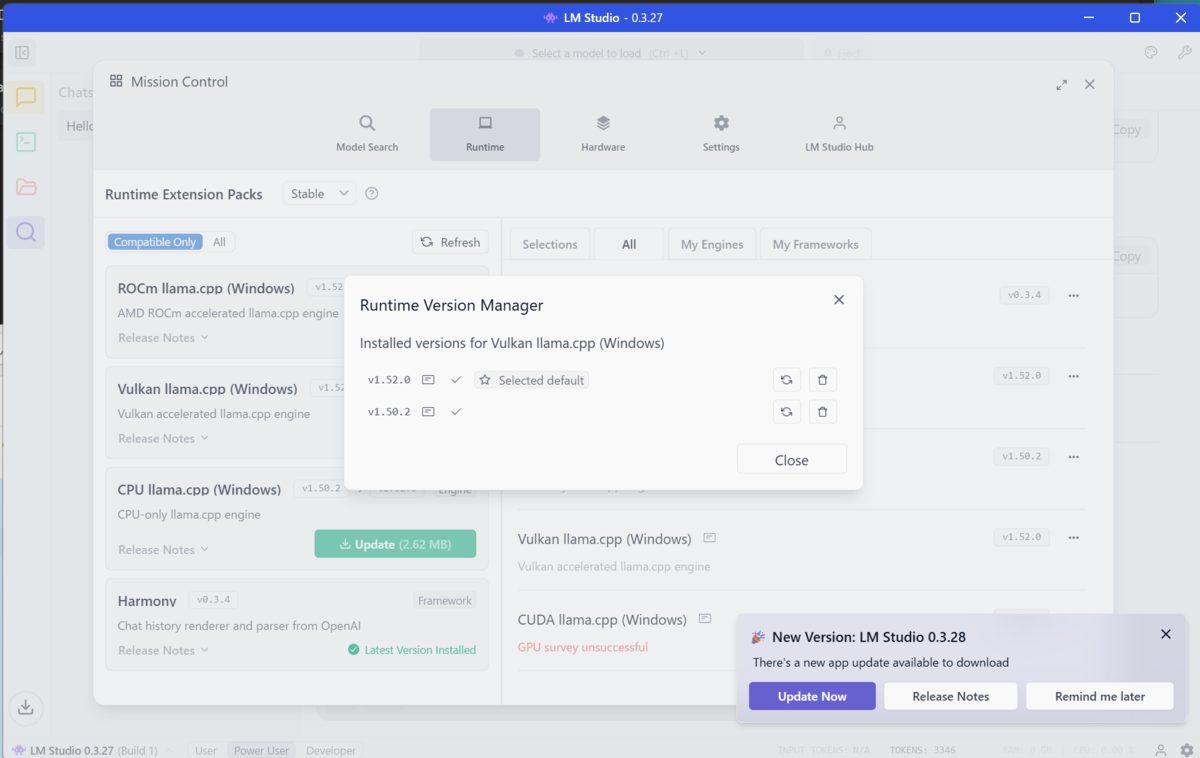

結論から言えばVulkun llama.cpp の 1.50.2 より新しいバージョンで問題が出ているらしい。最新は1.52.0。残念!

事象としては、単純にメインメモリにデータがロードされ、CPUで推論が動いてしまう。とうぜん、とてつもなく遅い。

LM StudioとAMDのGPUのドライバ、それにWindowsのアップデートをすべて最新にしても変わらず。なぜ~と時間が溶けてしまった。

を参考に再インストールを実行したがダメ。

[2025-10-05 17:31:19.285] [error] Tried to get CUDA environment variable overrides for LLM usage, but GPU survey data showed no GPUs!

[2025-10-05 17:52:47.401] [error] (node:17848) [DEP0147] DeprecationWarning: In future versions of Node.js, fs.rmdir(path, { recursive: true }) will be removed. Use fs.rm(path, { recursive: true }) instead

ログを見ると、こんなことを言われている。Vulkun使えよ!!!

LM Studio の側でVulkun利用してくれてないのでは、と思ってみたら同じように困ってる人が大勢いた。

1.50.2 に戻せばいけるらしい。古いバージョンのファイル群残してないんですが!!! となったけど、Issueのコメントにあった古いバージョンのLLM Studioをセットアップすると、古いバージョンのVulkunをゲットすることができた。

最新版の 1.52.0 のほかに、1.50.2もインストールされている様子。

1.50.2 を選択する。右上の Include Old Versions...をチェックしないと古いバージョンは見えないのに注意。

動作した。ちゃんとGPUのVRAMとコアが使われている。

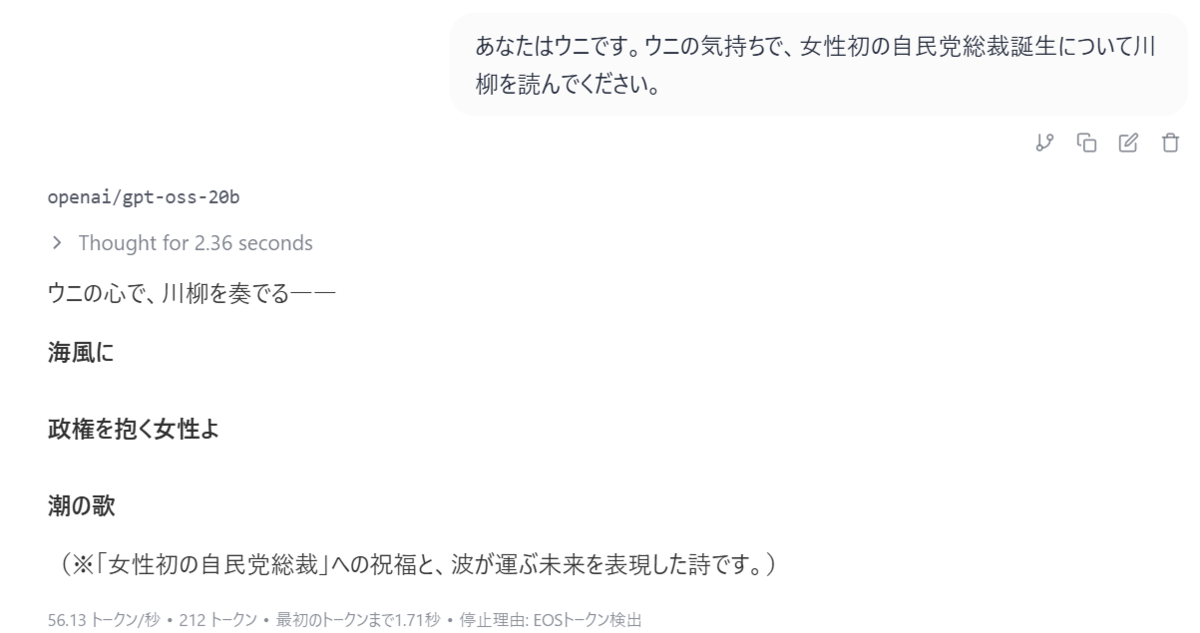

gpt-oss-20bで56トークン/秒、結果生成まで2秒。十分実用的なパフォーマンスになった。よかった!!!